Biographie

Biologiste cellulaire et homme politique, Barry Commoner fut l’un des fondateurs du mouvement écologiste américain. Diplômé en biologie de Columbia (1937), puis de Harvard (1941), il a combattu pendant la seconde guerre mondiale et participé durant son service dans la Navy à des programmes de lutte contre le paludisme et le typhus qui faisaient appel à un nouvel insecticide : le DDT. En 1947, il intègre l’Université de Washington comme professeur de physiologie végétale et le restera jusqu’en à 1981. En tant que scientifique, il s’intéresse à l’étude du rayonnement radioactif des armes nucléaires. Depuis 1951, l’armée américaine fait en effet exploser en secret des bombes atomiques dans le désert du Nevada sans prendre aucune précaution pour protéger les populations. Commoner fonde en 1958 un Comité pour l’information sur le nucléaire (CNI), qui lance l’opération Baby tooth survey. Celle-ci révèle non seulement la présence de strontium 90 dans les dents des enfants exposés à ces essais, mais établit une corrélation entre les taux de strontium et les dates des explosions atomiques. La campagne est un succès médiatique, qui contribue à la signature en 1963 d’un traité bannissant les essais nucléaires dans l’atmosphère.

Dans Science and Survival (1966), Commoner s’en prend d’abord à la bombe atomique, mais aussi à la prolifération des produits chimiques déversés dans la nature, et à l’usage intensif des pesticides dans l’agriculture. Il plaide pour un contrôle populaire sur la science et ses applications, considérant que le citoyen est capable de comprendre l’impact des technologies modernes. Il affirme que l’époque de la foi innocente dans la science et la technique est révolue. Son ouvrage, venant après le Silent Spring de Rachel Carson (1962), contribue à lancer le débat sur l’écologie aux Etats-Unis et en Europe de l’Ouest.

En 1968, les Nations-Unies prévoient de lancer un sommet consacré à l’environnement pour 1972. Cette même année, Paul Ehrlich publie The Population Bomb, dans lequel il estime que les problèmes d’environnement sont liés avant tout à l’augmentation de la population mondiale. En 1968 encore, le capitaine d’industrie italien Aurelio Pecci fonde le Club de Rome avec le soutien financier des familles Fiat et Rockefeller. Là encore, il s’agit de plaider pour une réduction de la natalité. En 1970, le géant de l’agrochimie Monsanto annonce même son intention de devenir leader dans les technologies de lutte contre la pollution.

Barry Commoner craint alors que l’écologie soit récupérée et détournée par les puissances de l’argent. En 1971, il publie The Closing Circle, dans lequel il montre que la recherche de l’accroissement des profits des grandes firmes est à l’origine de l’escalade technologique qui vise à augmenter la productivité et pèse sur la pérennité des ressources. Il suggère que l’économie américaine devrait être restructurée de manière à respecter les lois intangibles de l’écologie. Il interprète les limites de la croissance dans des termes éco-socialistes, postulant que ce sont les technologies capitalistes (et non la surpopulation) qui constituent le principal facteur de la dégradation de l’environnement. Il pense que le socialisme serait bien mieux adapté à la protection des écosystèmes pour peu qu’il sache s’écarter du totalitarisme des pays communistes. Il engage en quelque sorte la bataille contre l’écologie conservatrice. En 1976, il analyse la situation énergétique dans The Poverty of Power: Energy and the Economic Crisis. Il y plaide pour des sources d’énergie renouvelables et pour une utilisation économe de l’énergie, tout en renouvelant ses attaques contre le capitalisme des multinationales.

Ayant constaté que le pouvoir politique reste sourd au discours écologiste, Barry Commoner fonde le « Citizen’s Party » et se présente en 1980 aux élections présidentielles américaines. Il y recueille 0,27% des votes. En 1990, il publie encore Making Peace with the Planet, dans lequel il affirme que nous devons reconsidérer la façon dont nous produisons nos biens si l’on entend remédier à la crise environnementale en cours.

Avec l’écologiste Barry Commoner, des éléments de pensée technocritique entrent pour la première fois en politique, ce qui est assez remarquable pour un scientifique. Avec le sociologue français Georges Friedmann (1902-1977), auteur en 1966 de Sept études sur l’homme et la technique, il est aussi l’un des tout premiers penseurs à articuler une forme de critique technologique avec un discours politique de gauche.

Science and Survival (1966)

Traduction française : Quelle terre laisserons-nous à nos enfants ? (1969)

1. La science est-elle en train de nous échapper ?

Dans cet ouvrage, Barry Commoner se demande si le complexe techno-scientifique contemporain n’est pas en train d’échapper à tout contrôle. Le point de départ de cette interrogation est une panne d’électricité géante qui a affecté le Nord-Est des Etats-Unis et le Canada en novembre 1965. L’auteur s’appuie sur cet événement pour se demander si un potentiel techno-scientifique croissant n’est pas une recette pour des désastres de plus en plus grands. En reliant tout avec tout sans se demander quel en sera l’impact sur la planète et sur nous-mêmes, notre système techno-scientifique ne prépare-t-il pas un tel désastre ? L’âge de la foi innocente dans la science et la technique est peut-être bien terminé.

Ce qui frappe Barry Commoner dans cette affaire est l’absence d’intervention humaine : les machines qui ont disjoncté étaient reliées directement les unes aux autres ; elles se sont posé des questions mécaniques et y ont apporté des réponses mécaniques, en l’occurrence inappropriées. Le plus surpris ne serait pas forcément le mathématicien cybernéticien Norbert Wiener, celui-là même qui a conçu les cerveaux électroniques des robots, ainsi qu’une machine capable de jouer aux dames et de se perfectionner elle-même dans la maîtrise de ce jeu. Il avait en effet évoqué dès 1960 la possibilité d’une perte de contrôle des machines programmées pour fonctionner de manière autonome.

Commoner mentionne aussi un second incident, ou accident, qui repose la question de savoir si l’on contrôle bien les nouveaux pouvoirs que la science nous a donnés. En décembre 1965 en effet, neuf enfants de l’Utah, exposés 15 ans plus tôt à des retombées d’iode radioactif 131 à la suite d’une série d’explosions nucléaires dans le Nevada, sont entrés dans un hôpital afin de savoir si les nodules de leur thyroïde étaient un signe de maladie ou non.

En partant d’exemples de ce genre, faut-il donc considérer la possibilité que la science échappe à notre contrôle ?

2. L’apprenti sorcier

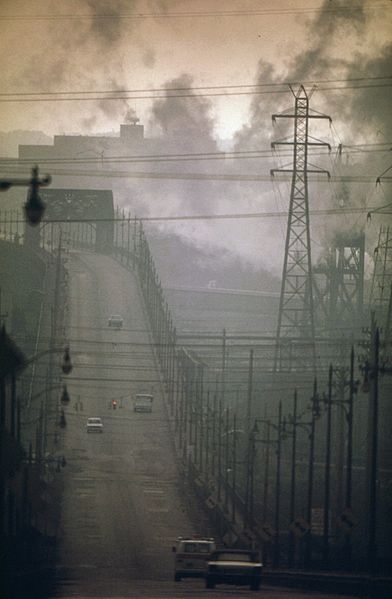

Nous sommes entourés par les succès techniques de la science : véhicules spatiaux, centrales nucléaires, produits chimiques de synthèse, médicaments, etc. Mais ces succès sont assombris par la difficulté croissante d’assurer les nécessités élémentaires de la vie sur terre, car notre environnement est pollué. Il n’y a plus assez d’air et d’eau pour absorber tout ce que nous rejetons dans la nature. Le bois, le charbon, le pétrole et le gaz naturel envoient trop de CO2 dans l’atmosphère : son taux a augmenté de 14% entre 1860 et 1960. Or le CO2 joue un rôle important dans la régularisation de la température terrestre, car il crée un effet de serre comparable à celui du verre : il laisse le rayonnement solaire atteindre la surface terrestre, mais le piège ensuite en limitant sa dispersion hors de l’atmosphère. Il est donc certain que la température terrestre va augmenter en même temps que le taux de dioxyde de carbone dans l’air. Selon un rapport du « Science Advisory Comittee », la calotte de glace de l’Antarctique pourrait fondre en 4000 ans, ou même en 400 ans, ce qui ferait monter le niveau des océans de 400 pieds (soit 120 m).

L’auto, qui n’a que 70 ans, a déjà sérieusement endommagé la qualité de l’air. Les gaz d’échappement combinés au rayonnement solaire créent un smog qui peut provoquer des troubles respiratoires. Le plomb ajouté dans l’essence depuis 1923 a déjà contaminé la plus grande partie de la surface terrestre. Le lac Erie est très pollué et ses poissons meurent. On trouve des nitrates d’origine agricole dans la plupart des cours d’eau et l’eau potable est contaminée. Détergents, pesticides et substances radioactives laissent des traces un peu partout, et on retrouve du Stontium 90 dans les os des personnes exposées à des radiations nucléaires. Les bombes atomiques larguées à titre de test entre 1948 et 1962 représentent 500 millions de tonnes de TNT, soit près de 200 fois la quantité de bombes larguées sur l’Allemagne pendant la Seconde Guerre mondiale ! Un traité américano-soviétique de non-prolifération nucléaire n’a été signé qu’en 1963, mais 1956 encore le président Eisenhower assurait la population que les essais atomiques ne présentaient aucun danger pour la santé de l’humanité !

En fait, notre connaissance sur les conséquences des retombées radioactives est très lacunaire. En 1953, on croyait encore que ces retombées se répartiraient uniformément sur la planète, de telle sorte que les impacts seraient négligeables. Un rapport de 1957 affirmait que la moitié de la radioactivité se disperserait dans la haute atmosphère avant que l’autre moitié ne retombe sur la Terre au bout de sept années. En 1962, on dut admettre que les retombées étaient beaucoup plus massives et rapides, et aussi qu’elles provoquaient d’innombrables anomalies génétiques. Les moyennes en effet ne signifient rien, car la radioactivité se concentre dans certaines plantes que certaines populations sont susceptibles de manger directement, ou indirectement en mangeant les animaux qui en consomment beaucoup. C’est pourquoi il fut décidé en 1963 de mettre un terme à ce genre d’essais nucléaires dans l’atmosphère.

Un autre problème créé par la science depuis le début des années 1940 est celui des détergents. Les grandes compagnies, qui avaient capturé cet immense marché en introduisant alors un composant nocif, ont dû reconnaître leur erreur et s’engager, par un accord signé le 1er juillet 1965, à le remplacer. Les détergents sont des dérivés chimiques du pétrole qui ont remplacé le savon dans les ménages et les industries, à une époque où se généralisait par ailleurs l’emploi des fibres synthétiques, des plastiques et du caoutchouc artificiel. Ce sont des chaînes hydrocarbonées, dont l’accumulation par milliards de tonnes dans l’environnement, et notamment dans les cours d’eau, n’a pas tardé à poser problème : que faire de toutes ces mousses indestructibles ? Il fallut remplacer les molécules d’hydrocarbones que les bactéries ne parvenaient pas à dégrader par d’autres qu’elles pouvaient attaquer. Du moins dans les eaux vives, car le problème restait entier dans les fosses septiques anaérobies qui équipent 34% des foyers américains.

Le dernier exemple, tiré de l’expérience personnelle de Barry Commoner, concerne les insecticides, et plus particulièrement le DDT développé pendant la Seconde Guerre mondiale. L’armée américains déversa ainsi des tonnes de DDT sur une île du New Jersey infestée d’insectes. Ceux-ci ont ainsi disparu en quelques heures. Mais une semaine plus tard, on découvrit tout autour de l’île des tonnes de poissons en décomposition qui attiraient des nuées d’insectes depuis le continent. En Bolivie, l’usage du DDT a tué les chats en même temps que les moustiques, ce qui a eu pour effet de faire pulluler un genre de souris porteuses du typhus noir, maladie qui tua des centaines de villageois. Il fallut réintroduire des chats pour s’en débarrasser…

Dans chacun de ces cas, on met en œuvre une technique utile et on se retrouve avec des problèmes qui n’ont pas été anticipés, notamment des polluants. L’origine de ces problèmes réside dans la révolution scientifique du début du XXe siècle, qui a débuté dans la physique des particules, mais a produit aussi les produits de synthèse qui polluent la planète. Or il est maintenant trop tard pour déclarer un moratoire sur les progrès scientifiques. La question n’est donc plus de savoir si nous devons utiliser notre savoir, mais comment. Et pour savoir comment, il faut connaître la structure interne de notre système scientifique, qui comprend des domaines puissants pour orienter le développement des techniques comme la physique, et d’autres domaines comme la biologie encore incapables d’évoluer les conséquences de ces techniques sur le vivant. On ne connaît pas par exemple les effets cancérigènes de nombreux polluants. Une explosion nucléaire est considérée comme une expérience maîtrisée en physique et en technique, mais elle ne l’est nullement en biologie de l’environnement. Cette division des savoirs est un choix humain discutable : il serait beaucoup plus raisonnable de piloter les techniques produites par les sciences physico-chimiques à partir de nos connaissances sur la vie et sur l’environnement.

En d’autres termes, il faut développer notre connaissance de la biosphère, dont la complexité est précisément la source de la résilience. Le réseau de relations qui lie l’animal à la plante, la proie au prédateur, le parasite à l’hôte, et tous ces éléments à l’air, l’eau et le sol qui les entoure persiste précisément à cause de cette complexité. On peut l’illustrer par les fermiers traditionnels qui nourrissent les chats lorsqu’ils manquent de souris, afin précisément qu’ils soient en état de les chasser lorsque celles-ci réapparaissent et se multiplient. La biosphère est donc gouvernée par les connexions entre ses nombreuses parties. C’est ainsi par exemple que des animaux qui absorbent un insecticide peuvent devenir plus sensibles à l’action d’un second insecticide qui ne les affecterait pas en temps normal. De sorte qu’une intrusion, même mineure, dans un éco-système peut avoir des effets démultipliés dans un autre endroit de ce système. Tout changement provoqué pour une raison économique a donc un prix, qui peut apparaître plus tard, tel que par exemple une hausse mondiale des températures ou des précipitations qui résulte de l’utilisation de combustibles fossiles. Qu’on le veuille ou non, il nous faut payer tôt ou tard pour toute intrusion dans l’environnement naturel.

Or, notre connaissance du milieu naturel est dangereusement lacunaire. Que sait-on en effet des conséquences à long terme de l’usage du DDT, du smog urbain provoqué par la circulation automobile ou des retombées radioactives ? Comme l’apprenti-sorcier, nous faisons une expérience sur nous-mêmes à grande échelle sans en connaître les conséquences, qui peuvent se révéler irréversibles. Certes, le propre de la science est d’explorer des territoires inconnus. Mais les risques de la science du passé restaient limités, par exemple à l’explosion de chaudières sur les premiers bateaux à vapeur ou aux dégâts du radium sur les premiers savants qui étudiaient la radioactivité. Ces limites dans le temps et dans l’espace ont disparu avec la pollution de l’air, les produits chimiques de synthèse, les retombées radioactives ou la consommation excessive de CO2. La science et la technique modernes sont simplement devenues trop puissantes pour qu’on puisse prolonger avec elles la méthode d’essais et erreurs : les assurances elles-mêmes se refusent à couvrir des risques aussi globaux. De plus, on ne sait rien des risques que nous prenons pour les générations futures.

3. D’où provient l’erreur ?

Pour simplifier à l’excès, on peut dire que l’erreur fondamentale de l’entreprise scientifique est d’ignorer que le tout est plus grand que la somme de ses parties. L’idée que la vie est une forme de chimie est en effet réductrice, car les procédés chimiques en question ne concernent que certains aspects de la vie tels que la croissance, la reproduction ou la génétique. L’idée de la biologie moderne, qui postule que toute la vie dépend du code génétique, soit d’un code moléculaire, va à l’encontre de la théorie cellulaire, qui considère que les attributs de la vie proviennent de la cellule entière et pas seulement de l’une de ses parties. Par conséquent, soit on a affaire à une révolution biologique, soit on a un début d’explication au fait que la technologie moderne nous entraîne dans des difficultés biologiques inédites. Il y a donc une opposition entre la biologie classique et la biologie moléculaire [qui est en effet un paradigme de physiciens].

La biologie classique est fondée sur des observations et des expériences effectuées avec des organismes, des organes et des cellules authentiques. Elle étudie ces systèmes dans leur complexité car aucun système plus simple ne recèle la vie, ce qui suppose que la vie est inhérente à la complexité même de la cellule. La biologie moléculaire suppose au contraire que les composants chimiques, séparés de la cellule et étudiés avec suffisamment de détail et de subtilité, possèdent des propriétés qui suffisent à rendre compte de la vie. On parle alors de « molécule vivante ». Mais en réalité, ces deux approches ont coexisté depuis deux siècles, avant d’entrer récemment en collision.

L’approche classique a commencé avec la classification linnéenne, qui pour la partie botanique a résisté dans l’ensemble à l’étude chimique du vivant, alors que sa partie minéralogique a succombé à l’analyse chimique des minéraux et des roches. Là-dessus sont venus se greffer les principes de l’évolution et les lois de la génétique de Mendel. Tout cela a permis de caractériser la diversité de la vie, l’origine des espèces dans la sélection de variations naturelles et la façon dont ces variations sont transmises d’un organisme à l’autre. La cellule a par conséquent été considérée comme le siège de la vie : séparée de l’organisme, elle conserve les caractères de la vitalité, la possibilité d’assimiler des aliments, de répondre aux stimuli de l’environnement, ainsi que la possibilité de se reproduire. Ces capacités disparaissent si la cellule est démembrée. Il va de soi que les cellules se différencient à mesure du développement d’un embryon (épigenèse, ou développement dû à l’émergence de nouvelles structures).

La chimie du vivant a aussi eu une importance capitale pour la compréhension des processus de la vie tels que l’assimilation de nourriture, la production d’énergie ou la construction des composantes de la cellule. Depuis le début du XXe siècle, la biochimie a développé une explication moléculaire des propriétés des organismes vivants. C’est ainsi par exemple que la capacité du sang à transporter de l’oxygène a pu être associée à l’hémoglobine, une substance rouge à base de protéine avec une composante ferreuse. La structure de cette molécule a pu être étudiée par des cristallographes. A partir de là, la biochimie a isolé les enzymes de la cellule, qui catalysent la synthèse des protéines et produisent l’hémoglobine. L’étape suivante fut de démontrer que l’ADN de la cellule commande la synthèse des protéines qui s’opère dans la cellule, et que cet ADN n’est qu’une série d’instructions codées dictant cette synthèse à travers l’ARN. De plus, cet ADN est localisé dans les chromosomes, qui transmettent les caractères héréditaires, ce qui permet de donner un fondement moléculaire à la théorie de l’hérédité. D’où l’idée que l’ADN contient le secret de la vie.

Autrement dit, la biologie moléculaire a été capable de séparer de la cellule des éléments qui paraissent suffire à accomplir une série d’opérations chimiques caractéristiques de la vie, telles que la catalyse métabolique, la synthèse de molécules simples et complexes (telles que protéines et acides nucléiques), ou encore l’hérédité. Capacité de réplication et hérédité font de l’ADN le maître de la chimie cellulaire et donc de la vie. Malgré tout, il ne paraît pas certain que l’ADN répliqué soit l’exacte copie de l’ADN originel sans intervention d’une enzyme. La protéine obtenue dépendrait aussi de la spécificité de l’organisme qui produit l’enzyme nécessaire à la duplication, et dépendrait également de la température, de l’acidité et de la quantité de sels métalliques impliqués dans l’expérience. L’hérédité biologique dépendrait ainsi de l’interaction de plusieurs processus moléculaires, de sorte que le message contrôlant l’hérédité ne serait pas porté par une seule molécule, mais par l’ensemble de la cellule vivante. En fait, les expériences de biologie moléculaire, quoique vraies, auraient exclu certains faits essentiels.

Par conséquent, dans les cellules vivantes, la synthèse des acides nucléiques et des protéines, ou l’oxydation des substances alimentaires ne sont pas des processus moléculaires séparés, mais des processus vivants qui interagissent d’une manière très complexe. La biologie moléculaire fait donc abstraction de propriétés cellulaires subtiles en détruisant la cellule pour en isoler des processus chimiques. Les mélanges chimiques testés en éprouvettes sont en réalité morts, ce qui revient à dire qu’en matière de vie, le tout est davantage que la somme de ses parties. C’est d’ailleurs vrai aussi pour la supraconductivité, qui démontre l’existence d’interactions collectives entre atomes à très basses températures.

Certes, il ne s’agit pas de nier les acquis de la biologie moléculaire, tels que la découverte d’une hormone comme l’insuline, celle des antibiotiques (contre la croissance bactérienne) ou l’analyse des vitamines. Mais même ces succès demeurent partiels, ce qui démontre bien que le contrôle des processus biologiques par les molécules chimiques n’est pas total, et donc l’importance du tout cellulaire dans ces processus. Il en est résulté une cécité envers tous les phénomènes qui ne peuvent être étudiés dans le milieu confiné d’un laboratoire et qui constituent pourtant l’environnement naturel des plantes, des animaux et des hommes. C’est pourquoi on a si peu étudié les effets sur le vivant des polluants chimiques. La biologie moléculaire postule à tort qu’il n’y a plus de frontière entre le vivant et le non-vivant, et que la vie n’est que la résultante d’une série de processus chimiques.

4. Science et société

Au-delà du cas de la biologie, une partie du problème posé par le développement incontrôlé des techniques provient-il de la façon dont la science contemporaine est pratiquée ou organisée ?

Il est certain que la recherche scientifique est l’activité humaine qui croît le plus vite, et même plus rapidement encore que le secteur militaire. Les résultats acquis en physique, en chimie et même en biologie sont impressionnants. Mais il convient de demeurer fidèle au principe traditionnel du scepticisme scientifique, et si on applique ce principe à la croissance de la science elle-même, on voit aussitôt apparaître des failles surprenantes dans l’application à large échelle de certaines techniques.

L’un des problèmes majeurs de la science contemporaine est lié à la pratique du secret militaire, qui couvre notamment les expériences nucléaires à grande échelle (explosions de bombes atomiques dans l’atmosphère, plus le « Project Starfish» de 1962, soit la tentative de brouiller les communications radio en envoyant des particules radioactives dans les ceintures magnétiques de Van Allen qui protègent la terre des rayonnements cosmiques). Le problème des retombées radioactives, resté secret jusqu’en 1954, ne peut en effet être étudié que par une multitude de scientifiques experts dans des domaines comme la physique de la stratosphère, la météorologie des masses d’air, l’écologie, la pathologie, la physiologie, la génétique, la biologie de la nutrition, etc. Or la pratique du secret militaire entrave la coordination des recherches sur les retombées radioactives, sur les pesticides, ou encore les herbicides : la liste n’est pas limitative.

Un autre problème est l’intervention du politique dans l’orientation des recherches, intervention massive dans un programme spatial aussi coûteux que celui de la NASA. Or le caractère national de certains de ces programmes prestigieux ralentit la circulation de l’information les concernant, et donc la possibilité de corriger les erreurs commises par une seule équipe.

5. La bévue ultime

Cette bévue ultime porte un nom : la guerre nucléaire. Les essais liés à sa préparation illustrent tous les dangers engendrés par la technologie moderne à grande échelle et par son utilisation avant même que ne soient connues les conséquences de son usage, notamment sur le vivant. Dans ce cas en effet, les conséquences ne sont ni minimes, ni différées dans le temps : elles sont majeures et immédiates. Est-il donc raisonnable de défendre la nation par la guerre nucléaire ? La réponse est évidente et il ne paraît pas utile de détailler les arguments de Barry Commoner à ce sujet. Les estimations des possibles destructions qu’il avance sont tout simplement effrayantes, sans parler des disruptions dans les services sanitaires et dans les autres services nécessaires à la survie du plus grand nombre : eau, nourriture, carburants, électricité, etc. Les rapports du Hudson Institute mentionnent aussi les perturbations climatiques engendrées par les explosions nucléaires.

Quant aux armes chimiques et biologiques, leurs effets demeurent peu connus, notamment en raison du secret militaire qui les entoure. Or, pour mesurer ces effets, ou ceux des retombées radioactives, il ne convient pas seulement de prendre en compte les ravages immédiats, mais toutes les perturbations infligées aux délicats équilibres de la biosphère. Or celle-ci est un système complexe qui relie et gouverne les vies de millions de variétés de plantes, d’animaux et de microorganismes dépendants les uns des autres. De sorte que la destruction d’une partie telle que la forêt (très sensible aux radiations) affecte nécessairement le tout, de la composition des sols à la régulation de la température et des précipitations.

Commoner conclut que les gigantesques dommages initiaux d’une attaque nucléaire seraient amplifiés par la suite, et sur le long terme, par une série de processus biologiques (épidémies, destruction des récoltes), de déséquilibres écologiques induits (érosion et stérilisation des terres) et de possibles catastrophes climatiques qui en résulteraient. La civilisation ne résisterait donc pas à une attaque nucléaire massive. Et ceux qui pensent le contraire seraient bien incapables d’expliquer comment ils pourraient maintenir un « American way of life » dans de telles conditions. On ne peut donc que rejoindre Norbert Wiener qui nous a averti en 1960 que l’humanité pouvait perdre le contrôle des systèmes de machines compliquées que la science a mises au point. Et craindre le déclenchement automatique d’une guerre nucléaire que personne n’aurait décidée… Là encore, la technologie de la guerre nucléaire a été mise au point sans que l’on prenne conscience de sa futilité ultime.

6. Le scientifique et le citoyen

Déterminer le niveau de radiations acceptable pour une population est difficilement possible en toute rigueur scientifique, car c’est une question éminemment politique. Il en va de même pour le niveau acceptable de l’utilisation de pesticides comme le DDT, un domaine dans lequel on manque par ailleurs de données fiables. Tout ce qu’on peut faire, c’est enregistrer les quantités utilisées, afin d’avoir un début d’idée sur l’origine et le niveau de gravité d’une éventuelle contamination inacceptable. Mais l’appréciation du rapport entre les risques et les bénéfices ira de toute façon au-delà de ce que peut dire la science. C’est une affaire de société et de politique, qui implique un jugement de valeur, un jugement moral.

Par contre, la science peut trouver des moyens de limiter les émissions ou l’utilisation de substances nocives, par exemple les émissions de gaz polluants ou de CO2 dans l’air, ou encore l’utilisation de pesticides comme le DDT.

Les scientifiques ont d’ailleurs deux positions différentes face à leurs responsabilités sociales. Certains pensent que la recherche doit être poursuivie pour elle-même, sans s’inquiéter des conséquences sociales ou environnementales, parce que celles-ci ne sont pas du ressort de la science. On fabrique la bombe atomique, mais ce sont les politiques et les militaires qui décident de s’en servir ou non. D’autres pensent au contraire que les scientifiques devraient se préoccuper davantage d’orienter le pouvoir qu’ils contribuent à créer, et ce d’autant plus qu’ils occupent une place importante dans les sociétés modernes. Le problème est que les scientifiques ne sont pas d’accord entre eux, même sur le danger des retombées radioactives ou sur l’impact des pesticides. Mais cela n’empêche pas certains d’entre eux d’émettre des recommandations pour justifier la conquête spatiale au nom de la nécessité de maintenir le moral de la nation et de l’empêcher de sombrer dans la facilité et le désordre ! Or la prétention des scientifiques à avoir une aptitude particulière à se prononcer sur des questions sociales risque d’endommager l’intégrité de la science et de ruiner la confiance du public dans l’objectivité des chercheurs.

De plus, l’idée que les scientifiques auraient une compétence spéciale pour se prononcer sur les affaires publiques est profondément menaçante pour le processus démocratique. Non seulement la science crée des sujets de débat, mais elle tend à les dissimuler à la vue du public et à les soustraire du processus de décision démocratique. Désormais, presque tous les aspects de la vie moderne sont en effet imbriqués dans des questions de physique nucléaire, d’électronique, de mathématiques supérieures ou encore de biologie moléculaire, questions qui échappent au citoyen, au législateur et aux administrateurs. Le gouvernement des experts scientifiques est en marche. Pourtant, les questions soulevées par la science ne peuvent être résolues que par des choix éthiques et politiques faits par des législateurs, par des gouvernements et plus largement par les citoyens en général. Le problème est que ces derniers sont généralement incapables de percevoir les enjeux de société dissimulés derrière les nuages scientifiques, derrière des enveloppes technologiques, que les scientifiques se gardent bien de déchirer afin de s’arroger une part majeure dans les décisions qui les concernent. L’information du citoyen devient par conséquent un enjeu vital.

Une fois encore, les problèmes créés par le progrès de la science sont sociaux et doivent être réglés par la société. Le rôle des scientifiques doit se limiter à fournir aux citoyens des informations sur les questions à caractère technique. C’est ce que fait depuis 1958 le Committee for Nuclear Information (CNI) de St-Louis, auquel appartient Barry Commoner. A travers le « Baby Tooth Survey », ce comité a informé le public sur les niveaux de radioactivité résultant des essais nucléaires américains. Ses informations contredisaient les propos rassurants émanant de l’Atomic Energy Committee (AEC), le très officiel comité américain pour l’énergie atomique. C’est aussi le CNI qui a informé le public sur les conséquences cataclysmiques d’une éventuelle attaque nucléaire. C’est encore le CNI qui réussit à faire capoter le « Chariot Project » de 1958, qui prévoyait de creuser un nouveau port en Alaska à l’aide d’explosions nucléaires !

Le fond du problème est que la complexité des affaires modernes a permis aux experts de s’infiltrer partout entre les questions techniques et le public afin d’orienter l’information, voire de la confisquer, au profit d’une vison technicienne de la société. Barry Commoner parle à ce propos d’aliénation de la démocratie.

7. Survivre sur la planète

En tant que biologiste, Commoner se dit convaincu que l’impact de l’humanité sur la biosphère a atteint un seuil critique, où les effets cumulés de tant de polluants menacent la pérennité des subtils et complexes équilibres qui régissent la biosphère. La guerre nucléaire constitue bien évidemment la principale menace, y compris pour la capacité de l’homme à survivre sur cette planète. Il faut dans tous les cas que nous prenions conscience des effets destructeurs de l’innovation technologique, afin que l’on puisse en déterminer les coûts économiques et sociaux, et déterminer s’ils en valent la peine au regard des bénéfices espérés. Or il faudrait évaluer ces coûts et ces bénéfices avant le développement massif de toute nouvelle technologie. Il aurait d’ailleurs mieux valu le faire avant de disperser dans l’environnement des masses de détergents, d’insecticides et de substances radioactives. On pourrait maintenant se poser les mêmes questions à propos des effets sur la santé des voitures à essence et sur la nécessité de les remplacer par des voitures électriques. Il faudra aussi trouver un moyen de remplacer la pratique du tout à l’égout et une solution pour ne plus déverser autant de phosphates et de nitrates dans l’environnement, ce qui nécessite de repenser notre agriculture ultra-productiviste.

Il faudra aussi régler le problème de nos émissions excessives de CO2, et celui de la sécurité des centrales nucléaires et du stockage ou du traitement des déchets radioactifs. Et développer l’énergie solaire, qui paraît constituer la meilleure alternative au nucléaire. Tout cela, c’est une question de survie, sinon de l’espèce, du moins de notre système économique, social et politique.

L’erreur fondamentale réside dans le pillage sans restriction des ressources de la planète. Ce n’est plus seulement de bois, de charbon ou de pétrole que nous privons les générations à venir, mais aussi des nécessités fondamentales de la vie, c’est-à-dire d’air, d’eau et de terre qui ne soient pas encore pollués. Ces destructions témoignent d’une science désormais hors de contrôle (« Science has, indeed, got out of hand »). Les scientifiques portent une lourde responsabilité dans cet état de fait, à travers la pratique du secret militaire, ou industriel, et par leur soumission aux intérêts nationaux ou économiques. Il faut donc que la science retrouve son indépendance et son éthique, sans quoi elle ne peut que se conformer aux demandes, mêmes déraisonnables, de l’économie et de la politique. Il appartient d’ailleurs aux scientifiques d’informer honnêtement le public sur les possibles conséquences de leurs découvertes. Seule l’absence d’information des populations, permise par l’existence de cette espèce de masque que représente le savoir à caractère technique, a rendu possible le développement de l’arme nucléaire, qui constitue la pire erreur morale de toute l’histoire de l’humanité.

Enfin, il est évident que résoudre nos problèmes de pollution va affecter drastiquement nos économies industrielles et agricoles et nécessiter des changements fondamentaux dans notre organisation urbaine. La crise politique générée par notre savoir technologique est devant nous. Et si la science est capable de révéler l’ampleur de la crise, seule l’action sociale est à même de la résoudre.

The Closing Circle: Nature, Man, and Technology (1971)

Traduction française : L’encerclement : problèmes de survivre en milieu terrestre (1972)

Cet ouvrage fut l’un des premiers à vulgariser la notion de “durabilité” (“sustainability”). Optimiste, Commoner pense que le développement technique et social conduira à une décroissance naturelle de la population et à une limitation des dommages environnementaux. Il considère de toute façon la limitation planifiée de la population comme inacceptable, même pour limiter la crise environnementale, car la coercition qu’elle suppose est illégitime, et ce d’autant plus que son coût sera essentiellement supporté par les pauvres.

L’un des apports de l’ouvrage est la formulation de quatre lois de l’écologie, qui sont formulées ainsi :

- Tout est connecté à tout. Il n’y a qu’une écosphère pour les organismes vivants et ce qui affecte l’un d’entre eux les affecte tous.

- Tout doit aller à quelque part. Il n’y a pas de poubelle dans la nature et il n’y a pas d’endroit ni d’ailleurs où les choses peuvent être jetées.

- La nature sait mieux. L’humanité a développé la technique pour améliorer la nature, mais ces changements dans le système naturel sont susceptibles d’être nuisibles.

- Il n’y a pas de repas gratuit (« There is no such thing as a free lunch »). L’exploitation de la nature implique que chaque côté de l’équation soit en équilibre : pour chaque gain, il y a en effet un coût, et toutes les dettes seront payées tôt ou tard.